楊丹,何建農(nóng)

(福州大學(xué) 數(shù)學(xué)與計(jì)算機(jī)科學(xué)學(xué)院,福建 福州 350116)

摘要:考慮到小波變換存在一些局限性,提出一種把非下采樣Contourlet變換(NSCT)與脈沖耦合神經(jīng)網(wǎng)絡(luò)(PCNN)相結(jié)合的圖像融合新方法。用NSCT變換從多尺度和多方向上分解配準(zhǔn)后的原始圖像。低頻應(yīng)用改進(jìn)的邊緣能量結(jié)合空間頻率的融合方法;高頻應(yīng)用PCNN簡(jiǎn)化數(shù)學(xué)模型,其鏈接強(qiáng)度用改進(jìn)的拉普拉斯能量和表示。并且選擇點(diǎn)火映射圖的點(diǎn)火次數(shù)與其標(biāo)準(zhǔn)差相結(jié)合的方法。最后經(jīng)過(guò)NSCT逆變換得出融合圖像。實(shí)驗(yàn)分析可知,與其他幾種圖像融合方法進(jìn)行比較,新方法取得了更高質(zhì)量的融合圖像。

關(guān)鍵詞:圖像融合;非下采樣輪廓波變換;脈沖耦合神經(jīng)網(wǎng)絡(luò);邊緣能量;拉普拉斯能量和

中圖分類(lèi)號(hào):TP391文獻(xiàn)標(biāo)識(shí)碼:ADOI: 10.19358/j.issn.16747720.2016.23.013

引用格式:楊丹,何建農(nóng). 一種新的結(jié)合NSCT和PCNN的圖像融合方法[J].微型機(jī)與應(yīng)用,2016,35(23):46-48,55.

0引言

圖像融合是將由不同傳感器獲得的圖像的重要信息進(jìn)行互相補(bǔ)充,得到一幅含有更加全面信息的新圖像,它能夠更加準(zhǔn)確地描述真實(shí)場(chǎng)景[1]。比較經(jīng)典的是小波變換方法,不過(guò)它只有點(diǎn)奇異性,而且方向受到限制,因此不能解決高維問(wèn)題。為了打破方向上的限制,相關(guān)學(xué)者又研究出了一些新方法,如Contourlet變換,它比小波變換處理的效果好,但其沒(méi)有平移不變性。所以,CUNHA A L等[2]對(duì)Contourlet變換作了改進(jìn),提出非下采樣Contourlet變換(Nonsubsanpled Contourlet Transform,NSCT),它有平移不變的性質(zhì)。脈沖耦合神經(jīng)網(wǎng)絡(luò)(PulseCoupled Neural Network,PCNN)是Eckhorn提出來(lái)的,它對(duì)圖像融合領(lǐng)域產(chǎn)生了重要影響。

1NSCT變換

NSCT變換是由兩個(gè)重要的部分構(gòu)成,它們分別為非下采樣金字塔濾波器組(NSP)和非下采樣方向?yàn)V波器組(NSDFB)[3]。用NSP從多尺度上分解輸入圖像,獲得低頻子帶、高頻子帶;用NSDFB從多方向上分解高頻子帶,獲得方向子帶。重復(fù)進(jìn)行這兩個(gè)操作就是對(duì)圖像進(jìn)行了NSCT變換。NSCT變換的工作流程中不包含上采樣和下采樣的環(huán)節(jié),因而擁有平移不變的性質(zhì),這是它與Contourlet變換的重要區(qū)別。圖1為NSCT的結(jié)構(gòu)示意圖。

2NSCT與PCNN相結(jié)合的圖像融合方法

2.1融合步驟

本文提出一種NSCT與PCNN相結(jié)合的新算法。具體步驟如下:

(1)利用NSCT變換分解原圖像A與B,獲得高低頻系數(shù)。

(2)低頻使用的是改進(jìn)的邊緣能量與空間頻率相結(jié)合的融合策略;高頻引入PCNN模型,其鏈接強(qiáng)度使用的是改進(jìn)的拉普拉斯能量和,選擇點(diǎn)火映射圖的點(diǎn)火次數(shù)與其標(biāo)準(zhǔn)差相結(jié)合的融合策略。

(3)對(duì)融合后的低頻系數(shù)CF(i,j)和高頻系數(shù)Ck,lF(i,j)作NSCT逆變換,取得融合圖像F。

2.2低頻融合規(guī)則

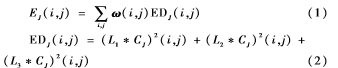

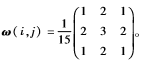

利用NSCT分解之后的低頻域表示圖像的大體輪廓,它是對(duì)真實(shí)場(chǎng)景的近似描述。因?yàn)榭臻g頻率可以表征圖像的活躍狀態(tài),邊緣區(qū)域能量能夠反映其邊緣特征。參考文獻(xiàn)[4]和[5]使用邊緣能量與空間頻率相結(jié)合的融合策略,能夠有效地保留圖像的邊緣細(xì)節(jié)信息,提高圖像的清晰度。改進(jìn)的邊緣能量定義:

式(1)中,ω(i,j)為窗口加權(quán)系數(shù)矩陣,為了突出窗口中心像素與其變化邊界,本文選取 式(2)中,L1、L2、L3為方向?yàn)V波算子,其值分別為:

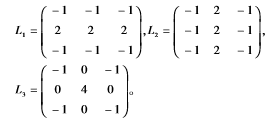

式(2)中,L1、L2、L3為方向?yàn)V波算子,其值分別為:

其中,EJ(i,j)為原始圖像J在像素(i,j)處的邊緣能量,J=A、B;CJ表示圖像的低頻系數(shù);表示卷積。

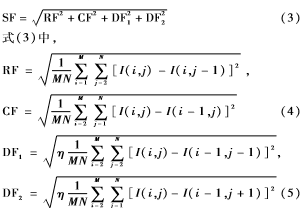

改進(jìn)的空間頻率定義為:

其中,SF為空間頻率;RF、CF分別表示行頻率和列頻率;DF1、DF2分別表示對(duì)角線為45°和135°時(shí)的頻率;I(i,j)為像素(i,j)處的灰度值;η=0.707。

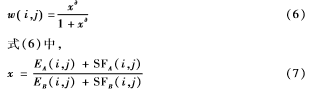

加權(quán)系數(shù)是通過(guò)對(duì)S函數(shù)[6]改進(jìn)得到的,本文改進(jìn)的S函數(shù)為:

w

其中,為收縮因子,本文取為5。

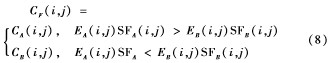

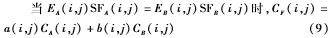

最終獲得的融合系數(shù)為:

其中,加權(quán)系數(shù) 為融合圖像F在像素(i,j)處的低頻融合系數(shù)。

為融合圖像F在像素(i,j)處的低頻融合系數(shù)。

2.3高頻融合規(guī)則

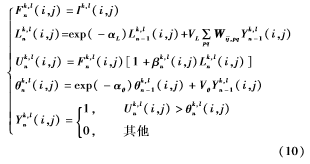

PCNN是由一些神經(jīng)元組合成的網(wǎng)絡(luò),每個(gè)神經(jīng)元都是由接受域、調(diào)制部分和脈沖產(chǎn)生器三個(gè)成分動(dòng)態(tài)非線性地構(gòu)成[7]。本文使用的是PCNN的簡(jiǎn)化模型,其數(shù)學(xué)模型如式(10)所示:

其中,(i,j)是神經(jīng)元所在的位置;Ik,l(i,j)為外部的輸入刺激;Fk,ln(i,j)為第n次迭代時(shí)的反饋輸入;Lk,ln(i,j)為鏈接輸入;Uk,ln(i,j)表示內(nèi)部活動(dòng)項(xiàng);θk,ln(i,j)為動(dòng)態(tài)閾值;αL、αθ為鏈接輸入和動(dòng)態(tài)閾值的時(shí)間常數(shù);VL和Vθ分別為Fk,ln(i,j)和Lk,ln(i,j)的放大系數(shù);p、q為鏈接范圍;Wij,pq為神經(jīng)元之間的鏈接矩陣;βk,ln(i,j)為鏈接強(qiáng)度;Yk,ln(i,j)表示輸出項(xiàng)。Uk,ln(i,j)>θk,ln(i,j)時(shí),輸出項(xiàng)Yk,ln(i,j)=1,則表示發(fā)生了一次點(diǎn)火;Tk,ln(i,j)為總點(diǎn)火次數(shù)。

高頻系數(shù)表示的是圖像的細(xì)節(jié)紋理信息,人的視覺(jué)更傾向于對(duì)這部分信息的關(guān)注。考慮到PCNN方法能夠更好地提取圖像的細(xì)節(jié)信息,所以本文在處理高頻方面引入PCNN模型。參考文獻(xiàn)[8]及[9],在PCNN的模型中,其刺激輸入采用高頻系數(shù),鏈接強(qiáng)度采用改進(jìn)的拉普拉斯能量和,融合規(guī)則選取點(diǎn)火次數(shù)與其標(biāo)準(zhǔn)差相結(jié)合的方法。此方法能夠更加充分地展現(xiàn)圖像的細(xì)節(jié)紋理特征。改進(jìn)的拉普拉斯能量和的定義:

其中,NSMLk,lJ(i,j)為輸入圖像J在k尺度l方向位于像素(i,j)處的拉普拉斯能量和,J=A、B;Ck,lJ(i,j)為輸入圖像J的高頻系數(shù)。

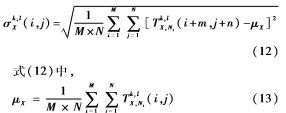

計(jì)算點(diǎn)火映射圖的標(biāo)準(zhǔn)差為:

其中,X=A、B;σk,lX為點(diǎn)火映射圖位于k尺度l方向上的標(biāo)準(zhǔn)差;Tk,lX,N1為點(diǎn)火次數(shù);μX為點(diǎn)火次數(shù)均值。

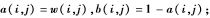

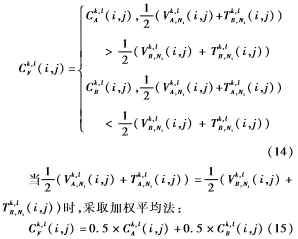

本文選擇PCNN的點(diǎn)火映射圖的點(diǎn)火次數(shù)與其標(biāo)準(zhǔn)差相結(jié)合的融合方法:

其中,Ck,lF(i,j)為融合圖像F在k尺度l方向上的高頻系數(shù)。

3仿真實(shí)驗(yàn)結(jié)果和分析

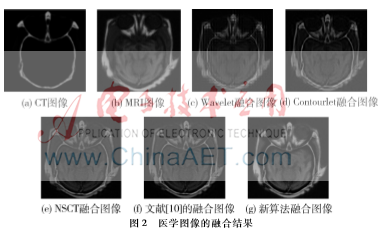

本文選擇了兩組精確配準(zhǔn)后的多聚焦圖像和醫(yī)學(xué)圖像進(jìn)行分析。通過(guò)用新算法與其他4種算法進(jìn)行比較,證明新算法的有效性。其他4種算法分別為:小波變換算法(WT)采用低頻取平均,高頻取大的融合方法;Contourlet變換算法中低頻采用取平均,高頻能量取大;NSCT算法采取低頻取平均,高頻采取絕對(duì)值取較大者的方法;文獻(xiàn)[10]中低頻選擇加權(quán)平均,高頻引入PCNN,其鏈接強(qiáng)度為拉普拉斯能量和。

從人眼視覺(jué)上對(duì)兩組圖像分別進(jìn)行分析。觀察圖2,圖2(c)出現(xiàn)明顯的頻譜失真現(xiàn)象,整體比較模糊。圖2(d)效果有所改善,但是骨骼、軟組織等信息損失較為嚴(yán)重。圖2(e)和(f)清晰度有所提高,但是具體細(xì)節(jié)紋理信息不夠清晰,圖(f)比(e)的效果好些。圖2(g)為新方法的結(jié)果,圖中的骨骼結(jié)構(gòu)、軟組織部分很清楚,亮度合適,有利于人眼觀察。

觀察圖3,圖3(c)中右邊的條形碼出現(xiàn)失真現(xiàn)象,圖中的字跡很模糊。圖3(d)比前者清晰,但是邊緣出現(xiàn)虛影。圖3(e)和(f)的效果有所改善,但是圖中的字跡不夠光滑。圖3(g)為新算法的結(jié)果,圖中的所有字跡都很光滑、清楚,能夠看出條形碼的細(xì)節(jié)紋理。

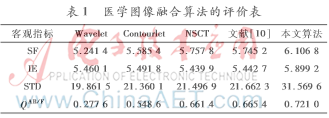

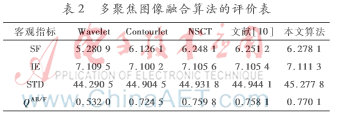

本文還使用了4個(gè)客觀指標(biāo)進(jìn)行評(píng)價(jià)。空間頻率(SF)表示圖像的空間活躍狀態(tài),數(shù)值越大其清晰度越高。標(biāo)準(zhǔn)差(STD)表示圖像的對(duì)比度,取值越大其對(duì)比度越高。信息熵(IE)是反映圖像保留下來(lái)的信息量的多少。QAB/F是表征邊緣信息的指標(biāo),取值越靠近1表明其效果越好。對(duì)表1和表2進(jìn)行分析可知,本文所提出的算法在這4個(gè)評(píng)價(jià)指標(biāo)上都比其他4種方法的數(shù)值大,由此證明新算法所得到的融合圖像效果是最好的。表

4結(jié)束語(yǔ)

綜合NSCT變換與PCNN的優(yōu)點(diǎn),本文采取把兩者相結(jié)合的圖像融合新算法。本文的關(guān)鍵之處是對(duì)高低頻融合方法的改進(jìn)。低頻應(yīng)用改進(jìn)的邊緣能量與空間頻率相結(jié)合的融合方法,高頻應(yīng)用PCNN模型,其鏈接強(qiáng)度為改進(jìn)的拉普拉斯能量和。并且通過(guò)點(diǎn)火映射圖的點(diǎn)火次數(shù)與其標(biāo)準(zhǔn)差相結(jié)合的方法選擇高頻融合系數(shù)。最后,對(duì)融合結(jié)果進(jìn)行主觀與客觀評(píng)價(jià),充分驗(yàn)證了新算法的有效性與可靠性。

參考文獻(xiàn)

[1] 周渝人, 耿愛(ài)輝, 王瑩,等. 基于對(duì)比度增強(qiáng)的紅外與可見(jiàn)光圖像融合[J]. 中國(guó)激光, 2014,41(9):223-229.

[2] CUNHA A L Da ,ZHOU J P ,DO M N. Nonsubsampled contourlet transform:theory,design, and applications [J].IEEE Transactions on Image Processing,2006,15(10):3089-3101.

[3] 李美麗, 李言俊, 王紅梅,等. 基于NSCT和PCNN的紅外與可見(jiàn)光圖像融合方法[J]. 光電工程, 2010, 37(6):90-95.

[4] WANG J, LI Q, JIA Z, et al. A novel multifocus image fusion method using PCNN in nonsubsampled contourlet transform domain[J]. Optik International Journal for Light and Electron Optics, 2015, 126(20):2508-2511.

[5] 鄭偉, 孫雪青, 李哲. shearlet變換和區(qū)域特性相結(jié)合的圖像融合[J]. 激光技術(shù), 2015,39(1):50-56.

[6] 劉衛(wèi), 殷明, 欒靜,等. 基于平移不變剪切波變換域圖像融合算法[J]. 光子學(xué)報(bào), 2013, 42(4):496-503.

[7] WANG Z B,MA Y D,CHENG F Y,et al.Review of pulsecoupled neural networks[J].Image and Vision Computing,2010,28(1):5-13.

[8] 李新娥, 任建岳, 呂增明,等. NSCT域內(nèi)基于改進(jìn)PCNN和區(qū)域能量的多光譜和全色圖像融合方法[J]. 紅外與激光工程, 2013, 42(11):3096-3102.

[9] CHAI Y, LI H, ZHANG X. Multifocus image fusion based on features contrast of multiscale products in nonsubsampled contourlet transform domain[J]. Optik International Journal for Light and Electron Optics, 2012, 123(7):569-581.

[10] 姜志.基于PCNN和NSCT變換的圖像融合算法研究[D].杭州:浙江理工大學(xué),2014.