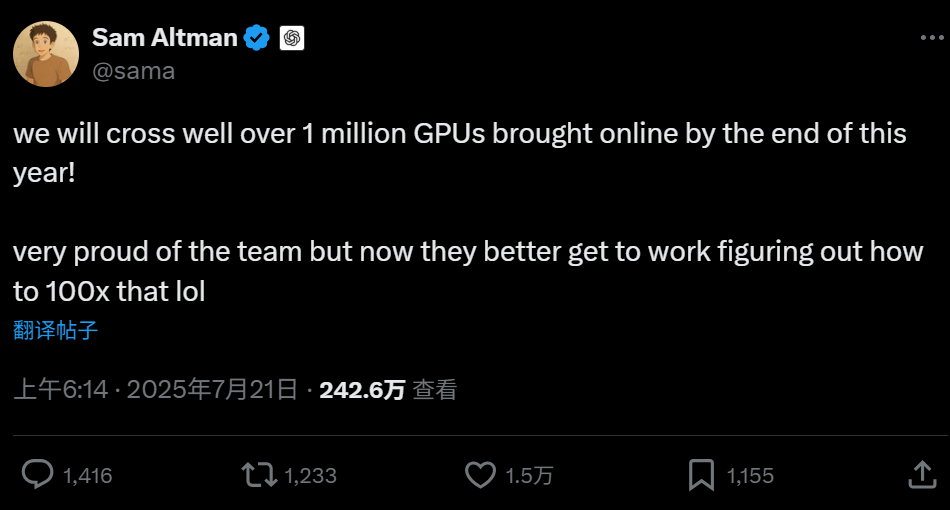

7月22日消息,OpenAI 首席執(zhí)行官山姆·奧爾特曼 (Sam Altman)近日在社交媒體平臺“X”上表示,OpenAI 有望在今年年底前“將超過 100 萬個 GPU 上線”。這一數(shù)數(shù)字將達到了埃隆·馬斯克 (Elon Musk) 的“xAI”訓(xùn)練Grok 4 所用的20萬個Nvidia H100 GPU的五倍。

早在今年 2 月,Altman就承認 OpenAI 不得不放慢 GPT-4.5 的推出速度,因為它們實際上“沒有足夠的GPU”。此后,Altman 將硬件計算資源擴展作為重中之重,除了尋求與微軟、軟銀等巨頭深度合作之外,還尋求與國家級規(guī)模的基礎(chǔ)設(shè)施運營商合作。當 OpenAI 在今年年底達到 100 萬個 GPU 的里程碑時,它還將鞏固自己作為全球最大的 AI 計算資源擁有者的地位。

值得注意的是,Altman還在“X”上表示,現(xiàn)在他們還想弄清楚如何將這個數(shù)字提高100倍。這確實是一個非常瘋狂的想法,因為按照目前的市場價格,1億個GPU的成本將達到約3萬億美元,這不包括其所需要的其他配套基礎(chǔ)設(shè)施的費用,而且英偉達和其芯片生產(chǎn)伙伴臺積電短時間內(nèi)也不可能生產(chǎn)出這么多的GPU,更不用說這1億個GPU所需要消耗的巨大能源,目前美國也缺乏強大的能源基礎(chǔ)設(shè)施。

OpenAI 的德克薩斯州數(shù)據(jù)中心就是一個例子,該數(shù)據(jù)中心現(xiàn)在是世界上最大的單一數(shù)據(jù)中心,其消耗電能約為 300 MW,這足以為一個中型城市供電,而且預(yù)計到2026年中期,能耗可能將達到1吉瓦。如此龐大的能源需求,已經(jīng)引起了德克薩斯州電網(wǎng)運營商的審查。他們警告說,為這種規(guī)模的站點穩(wěn)定電壓和頻率需要昂貴、快速的基礎(chǔ)設(shè)施升級,即使是州公用事業(yè)公司也難以與之匹配的。無論如何,創(chuàng)新必須占上風,泡沫不應(yīng)該破裂。

不過,“100倍”可能并不是一個確切的數(shù)字上的目標,而是關(guān)于達到 AGI(通用人工智能)所需要的算力,這意味著不論是GPU、定制芯片、還是其他新架構(gòu)的芯片,甚至是目前還沒的東西,OpenAI想找出答案。

目前,OpenAI也并不僅僅是采用英偉達的GPU,雖然目前微軟的Azure云仍然是其主要的云骨干網(wǎng),但 OpenAI 已與甲骨文合作建立自己的數(shù)據(jù)中心,并有傳言稱正在探索谷歌的 TPU 加速器以使其計算堆棧多樣化。

這是一場更大的軍備競賽的一部分,從 Meta 到亞馬遜,每個巨頭都在構(gòu)建自研的人工智能芯片,并在高帶寬內(nèi)存(HBM)上下大賭注,以維持這些龐大AI模型的需求。Altman也暗示了 OpenAI 自研AI芯片計劃,考慮到該公司對于AI芯片需求的規(guī)模不斷擴大,這是很有必要的。

Altma的最新評論也同時提醒人們,AI領(lǐng)域競爭有多激烈。一年前,一家擁有 10,000 個 GPU 的公司聽起來像是一個重量級競爭者,現(xiàn)在即使是 100 萬個GPU,也感覺只是邁向更大目標的又一墊腳石。OpenAI 的基礎(chǔ)設(shè)施的持續(xù)擴張,不僅能夠更快的訓(xùn)練,獲得更好的模型,并使其模型在云端被更多人使用時能夠更流暢的運行,以確保長期優(yōu)勢。

這對于AI模型或AI云服務(wù)的競爭者來說,并不是一件好事,因為這將使得他們不得不持續(xù)在AI基礎(chǔ)設(shè)施當中投入巨量的資金,并且短期內(nèi)恐怕難以收回成本。但是對英偉達等AI硬件廠商來說,這是一個好消息。