InfiniBand 互連是在上個世紀末關于服務器 I/O 未來的斗爭中出現的,它不是成為通用I/O,而是成為用于高性能計算的低延遲、高帶寬互連。在這個角色上,它無疑是成功的。

在過去的十五年中,InfiniBand已經擴展到用作與某些供應商的系統互連——IBM多年來將InfiniBand用作Power Systems和大型機上的外圍I/O總線,但從未如此稱呼過它。InfiniBand也被用作集群存儲主干,現在是進行機器學習訓練的AI集群的首選節點間網絡。如果您正在構建一個數據庫集群,您可能會選擇 InfiniBand 互連,例如 Oracle 為其 Exadata 系統所做的那樣。

20年后,事實證明,這是康奈利網絡(Cornelis Networks)聯合創始人之一、公司首席執行官菲爾·墨菲(Phil Murphy)的愿景的一個合理復制,在IBM和英特爾創建InfiniBand之后,他于1999年離開Unisys,并成立了SilverStorm Technologies,生產InfiniBand交換硬件和軟件。PathScale是一家InfiniBand主機適配器制造商,被光纖通道交換機和收購QLogic適配器制造商在2006年2月以1.09億美元的價格收購,隨后QLogic隨后在2006年10月以6000萬美元收購SilverStorm,以補充近6年前以1500萬美元收購Ancor Communications的InfiniBand交換機——有人說在InfiniBand交換機市場真正做好準備之前。

QLogic 將這些技術融合在一起,創建了 TrueScale InfiniBand 加載平臺,該平臺于 2012 年 1 月被英特爾以 1.25 億美元的價格收購,并在服務器節點的 CPU 內核上運行大量網絡軟件堆棧——英特爾顯然很喜歡這一點。僅僅三個月后,英特爾以1.4億美元的價格從Cray手中收購了“Gemini”XT 和“Aries”XC 互連業務,并著手打造 Omni-Path 互連,將 InfiniBand 的一些概念與 Aries 結合,創建一個新的一種適用于上述所有工作負載的高性能互連。Omni-Path 是“Knights”Xeon Phi 計算加速器和英特爾整體 HPC 工作的關鍵組成部分。三年前,Knights CPU 被淘汰了 Omni-Path 現在正在 Cornelis 的指導下開設一門新課程——墨菲說這個課程更適合高性能計算和存儲的當前和未來狀態。

關于 InfiniBand 協議的一些歷史是為了正確理解 Cornelis 將在其 Omni-Path InfiniBand 實施中做出的轉變。

“InfiniBand的軟件基礎設施,基于verbs,實際上是基于InfiniBand的最初目標,即取代PCI-X和光纖通道,或許還有以太網,”Murphy告訴The Next Platform:“verbs根本不是為高性能計算而構建的。PathScale創建了Performance Scale Messaging,或PSM,它完全獨立于InfiniBand verbs,是一個專注于 HPC 的并行傳輸層。在企業中,當與40或50個磁盤驅動器 40或50個隊列對通話時,可以將其放在我的適配器的緩存中,并且效果很好。但是在HPC中,當有一個具有一百個內核和一千個節點的節點時,這將成為一個巨大的可擴展性問題,我們無法在適配器的緩存中進行管理。PSM 可以做得更好,但即使這是在20年前發明的,世界也在不斷發展。我們看到 HPC、機器學習、數據分析的融合,現在也有加速器和 CPU 的混合。”

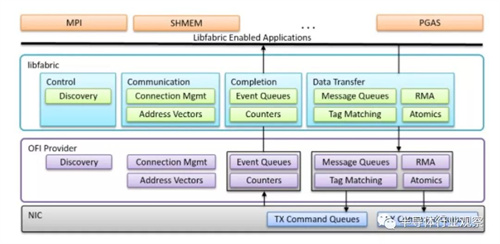

對 Cornelis 來說幸運的是,大約七年前,2004 年成立的 OpenIB 聯盟的研究人員和技術人員創建了 OpenFabrics 接口工作組,以擴展遠程直接內存訪問 (RDMA) 和內核旁路技術,從而通過融合以太網提供 InfiniBand 和 RDMA (RoCE) 它們的低延遲以補充其對其他類型網絡的高帶寬。所述libfabric庫是第一實施OFI標準的,并且其是上述網絡接口卡和OFI提供商驅動器和MPI,SHMEM,PGAS和其他存儲器共享協議之間跨在為HPC分布式計算系統通常運行一個層和人工智能。它看起來像這樣:

“所有主要的 MPI 實現都支持 libfabric,分布式計算系統的各種分區全局地址空間(PGAS)內存覆蓋也是如此,包括來自桑迪亞國家實驗室的OpenSHMEM 以及 Mellanox InfiniBand、Cray Gemini 和 Aries plus Chapel的PGAS 實現,和英特爾Omni-Path互連。動詞和 PSM 需要用某些東西替換,OFI 就是這樣。OFI不僅是為現代應用程序而設計的,它是從頭開始構建的,不僅可以識別節點中的 CPU,還可以識別加速器。這個 OFI 層是從網絡到應用層的完美語義匹配。”

在這一點上,Cornelis 的團隊自 2020 年 9 月揭開面紗以來已擴大一倍至 100 多人,他們為 OFI libfabric 創建了一個提供程序驅動程序,該驅動程序運行在 100 Gb/秒 Omni-Path 適配器之上,現在被替換為 Omni-Path Express。該適配器每秒可以驅動 1.6 億條 MPI 消息,并且可以在運行在網絡連接的兩個不同服務器節點上的任意兩個內核之間每秒驅動大約 1000 萬條消息。Murphy 表示,對于任何 InfiniBand 實施,您最多可能會看到每個內核 300 萬到 400 萬條消息,因此每個內核的帶寬增加了 2.5 到 3.3 倍。(顯然,為了跟上處理器核心數量的增加和每個核心的更高性能,Cornelis未來必須獲得更強大的 Omni-Path適配器。)至于延遲,對于最難改善延遲的小消息大小,Omni-Path Express 網絡的核心到核心往返現在約為 800 納秒,比使用舊 PSM 的 1 微秒往返低 20%司機。對于 HPC 和 AI 工作負載,這些都是帶寬和延遲方面的重大改進。

Cornelis 也關注成本。在 InfiniBand 的大多數實現中,每個套接字有一個端口比讓一個端口以兩倍的速度運行要好,我們懷疑如果可以的話,您希望將每個端口從每個套接字上物理掛起。(這就是 TrueScale在 InfiniBand QDR 時代的全部意義。) Cornelis 說,使用單端口 100 Gb/秒 Omni-Path 適配器和 100 Gb/秒 Omni-Path 交換機的集群網絡的成本將比Nvidia 100 Gb/秒 HDR InfiniBand Quantum 交換機和單端口 ConnectX-6 適配器設置的成本。對于網絡的雙軌實施,其中每個插槽都有自己的專用端口,Omni-Path 設置仍然便宜 25%。

Omni-Path Express 適配器和交換機現在處于技術預覽階段,大約有 20 位客戶,可能在 11 月左右,正好趕上 SC21 超級計算會議,Cornelis 將普遍提供這種更新的 Omni-Path 堆棧。這對于全球 500 家左右以 Omni-Path 網絡為集群核心的客戶來說將是個好消息。新的 OFI 功能有可能通過固件更新,幫助客戶在完全不接觸硬件的情況下提升性能。

至于未來,似乎將跳過200gb/秒的全路徑200系列,這是英特爾在2019年7月悄悄擱置的一代。這第二代的全能路徑是合并更多的Aries互連技術,顯然將打破向后兼容性-這是一個禁忌。Murphy說,Cornelis正在開發一種OFI適配卡,它有四個通道,每個端口以100Gb/秒的速度運行。我們推測配套的 Omni-Path Express 交換機可以有48到64個端口, 400 Gb/秒的最高速度運行,并且以 200 Gb/秒的速度運行該端口數的兩倍。這些未來的 Omni-Path Express 開關和適配器預計將在2022年末上市,我們也猜測這些芯片將采用5納米單片芯片設計,并使用中國臺灣半導體制造公司作為他們的代工廠。就像英特爾對原始 Omni-Path 芯片所做的一樣。