摘 要: 提出融合局部特征和整體特征的方法實(shí)現(xiàn)人臉" title="人臉">人臉面部表情特征的提取。在每一個人臉圖像上測量10個距離,把這些距離標(biāo)準(zhǔn)化后作為局部表情特征,用Fisher 線性判別提取面部表情的整體特征;為了解決小樣本問題,采取“PCA+FLD”的策略,先通過PCA把人臉圖像向量投影到一個較低維的空間,再通過標(biāo)準(zhǔn)的FLD提取表情特征。融合后的特征輸入到基于反向傳播的前向型神經(jīng)網(wǎng)絡(luò)進(jìn)行分類。在耶魯大學(xué)yaleface數(shù)據(jù)庫和日本ART建立的日本女性表情數(shù)據(jù)庫(JAFFE)上實(shí)驗(yàn),得到令人滿意的結(jié)果。

關(guān)鍵詞: 局部特征 整體特征 表情識別 FLD PCA 神經(jīng)網(wǎng)絡(luò)

隨著人機(jī)交互研究的深入和巨大的應(yīng)用前景,人臉面部表情識別已經(jīng)成為當(dāng)前模式識別和人工智能領(lǐng)域的一個研究熱點(diǎn)。在過去幾十年內(nèi),研究者已經(jīng)提出了很多用于面部表情識別的方法[1]。目前的人臉面部表情識別方法可以分為兩種:基于局部特征和基于整體特征的。基于局部特征的人臉面部表情識別是利用每個人的面部特征(眉毛、眼睛、鼻子、嘴巴和面部輪廓線等) 的位置、大小及其相互位置的不同進(jìn)行特征提取" title="特征提取">特征提取,達(dá)到人臉面部表情識別的目的。基于人臉整體特征的識別是從整個人臉圖像出發(fā),提取反映人臉整體的特征實(shí)現(xiàn)人臉面部表情識別。基于局部特征的方法很大程度上減少了輸入的數(shù)據(jù),但是用有限的特征點(diǎn)" title="特征點(diǎn)">特征點(diǎn)來代表人臉圖像,一些重要的表情識別和分類信息就會丟失。為了彌補(bǔ)局部特征的這些不足,本文用 Fisher 線性判別提取面部表情的整體特征,然后通過局部特征和整體特征的融合來提高識別率。Fisher準(zhǔn)則函數(shù)就是為了發(fā)現(xiàn)這樣的投影方向,使得樣本類間離散度和樣本類內(nèi)離散度的比值最大。換言之,就是在這樣的投影方向,同一個類的樣本聚集在一起,而不同類的樣本相對比較分散。

1 面部表情特征的提取

1.1 局部特征的提取

人臉由眼睛、鼻子、嘴巴、下巴等部件構(gòu)成,正因?yàn)檫@些器官的形狀、大小和相對位置的各種變化才使得人臉表情千差萬別。因此對這些器官的形狀和結(jié)構(gòu)關(guān)系變化的幾何描述,可以作為人臉表情識別的重要特征。最早,研究人員利用人臉特征顯著點(diǎn)導(dǎo)出一組用于識別的特征進(jìn)行人臉及其表情識別[2] 。本文在人臉圖像上標(biāo)記24個面部特征點(diǎn),如圖1所示。

由這24個面部特征點(diǎn)形成12個測量距離" title="測量距離">測量距離,距離與面部特征點(diǎn)之間長度的對應(yīng)關(guān)系如表1。表1中tij表示面部特征點(diǎn)i和j之間的直線長度,di表示第i個測量距離。

由這些測量距離歸一化,即按照下式形成表征面部表情的特征:

1.2 整體特征的提取

Fisher線性判別(FLD),也稱為線性判別分析 (LDA),是基于樣本的類別進(jìn)行整體特征提取的有效方法,在模式識別中有著廣泛的應(yīng)用。設(shè)訓(xùn)練樣本集共有N 個訓(xùn)練樣本{x1,…,xN},分為c類{x1,…,xc},每一類的均值為: μi=![]() xk;總均值為:μ

xk;總均值為:μ![]() xk;第i類樣本的離散度矩陣為:

xk;第i類樣本的離散度矩陣為:

由于最多只有c-1個非零廣義特征值,因此m的最大值為c-1。

在人臉面部表情識別研究中,所面臨的一個問題是小樣本問題,即用于訓(xùn)練的圖像數(shù)目N是遠(yuǎn)小于每幅圖像的像素數(shù)目。本文采用“PCA+FLD′策略,先將訓(xùn)練樣本的人臉圖像向量投影到一個較低維的空間,使類內(nèi)分布矩陣為非奇異的。可以通過PCA將特征空間降為N-c維,然后通過標(biāo)準(zhǔn)的FLD 將維數(shù)降為c-1。通過PCA將人臉圖像投影到N-c維特征空間:

需要指出的是, Wpca的優(yōu)化是基于由正交列向量組成的n×(N-c)維矩陣,而Wfld的優(yōu)化是基于由正交列向量組成的(N-c)×n維矩陣,在計算Wpca時只丟掉了最小的c-1維主成分向量。

2 前向型神經(jīng)網(wǎng)絡(luò)

本文用基于反向傳播算法的前向型多層神經(jīng)網(wǎng)絡(luò)識別人臉面部表情,為了更好地提高人臉面部表情的識別率,如何優(yōu)化設(shè)計網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)是關(guān)鍵。對于網(wǎng)絡(luò)的大部分參數(shù),采取實(shí)驗(yàn)修正的方法進(jìn)行確定。本文采用的網(wǎng)絡(luò)結(jié)構(gòu)為三層:輸入層有15個輸入單元對應(yīng)融合后的表情特征,隱含層用10個神經(jīng)元,網(wǎng)絡(luò)的輸出用兩個神經(jīng)元代表兩位二進(jìn)制數(shù)表示不同面部表情。基于反向傳播的前向型神經(jīng)網(wǎng)絡(luò)的基本思想是據(jù)樣本集S={(x1,y1),(x2,y2),…,(xs,ys)}中的每一個樣本(xk,yk)逐一計算出實(shí)際輸出Ok的誤差測度El,對W(1),W(2),…W(L)各做一次調(diào)整,重復(fù)此循環(huán),直到ΣEp<ε。

用輸出層的誤差調(diào)整輸出層權(quán)矩陣,并用此誤差估計輸出層的直接前導(dǎo)層的誤差,再用輸出層前導(dǎo)誤差估計更前一層的誤差。如此獲得所有其他各層的誤差估計,并用這些估計實(shí)現(xiàn)對隊矩陣的修改。形成將輸出端表現(xiàn)的誤差沿著與輸入信號相反的方向逐級向輸入端傳遞的過程。

本文采用基于隨機(jī)梯度下降版本的BP算法完成人臉面部表情的分析與識別。具體的算法描述如下:

(1)初始化,初始化所有網(wǎng)絡(luò)權(quán)值為小的隨機(jī)數(shù)。

(2)直到終止條件do

{

對于每一個訓(xùn)練樣本

do 把輸入向前傳播到網(wǎng)絡(luò)并計算被考察的輸出

按下式計算誤差,并把誤差反向傳播:

對于每個網(wǎng)絡(luò)輸出單元k,計算其誤差量δk=ok(1-ok)(tk-ok)

}

}

結(jié)束

3 實(shí)驗(yàn)過程和結(jié)果

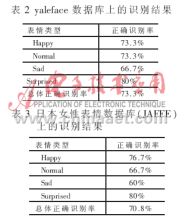

在兩個數(shù)據(jù)庫上進(jìn)行實(shí)驗(yàn),從耶魯大學(xué)的yaleface數(shù)據(jù)庫中選取60幅人臉圖像作為實(shí)驗(yàn)樣本,共15個人,4幅/人,其中訓(xùn)練樣本56幅,14個人;4幅/人;測試樣本為剩下的4幅圖像,1個人,4幅/人,通過隨機(jī)變換訓(xùn)練樣本和測試樣本,重復(fù)15次這樣的實(shí)驗(yàn)。從日本女性表情數(shù)據(jù)庫中(JAFFE)選取120幅圖像作為實(shí)驗(yàn)樣本,共10個人,12幅/人,其中80幅圖像作為訓(xùn)練樣本,10個人,8幅/人;測試樣本為40幅圖像,10個人,4幅/人。通過隨機(jī)變換訓(xùn)練樣本和測試樣本,重復(fù)12次這樣的實(shí)驗(yàn)。人臉面部表情識別的步驟如下:

(1)圖像的預(yù)處理。文獻(xiàn)[3]指出人臉識別" title="人臉識別">人臉識別的對象應(yīng)該是純臉(pure face),而不應(yīng)包括頭發(fā)、肩膀和背景等不相關(guān)的數(shù)據(jù)。如果待識別的人臉圖像中含有這些非純臉的信息,很有可能是這些信息對決策起關(guān)鍵作用,也不再是真正意義上的人臉識別。因此本文首先用人工的方法,對圖像做純臉部分的分割形成50×60的圖像。然后對純臉圖像進(jìn)行標(biāo)準(zhǔn)化和歸一化處理,以便表情特征的提取和面部表情的分析與識別。

(2)局部特征提取。首先在面部標(biāo)記24個面部特征點(diǎn),如圖1;然后按照表1的關(guān)系得到12個測量距離;最后按公式(1)把這些測量距離標(biāo)準(zhǔn)化后形成12維向量作為表征人臉面部表情的特征。

(3)整體特征的提取。用Fisher線性判別提取面部表情特征,關(guān)鍵是如何解決小樣本問題,本文采取“PCA+FLD”策略。在耶魯大學(xué)yaleface數(shù)據(jù)庫上用m=N-c=52維特征向量構(gòu)造特征子空間。在JAFFE上用m=N-c=76維特征向量構(gòu)造特征子空間,其中N為訓(xùn)練樣本數(shù)目,c為類別數(shù);然后FLD變換到c-1=3維特征空間作為表示面部表情特征的一部分特征。

(4)特征融合。本文表征面部表情特征的局部特征與整體特征融合在一起,形成15維特征,![]() ,把X輸入到神經(jīng)網(wǎng)絡(luò)的輸入層。

,把X輸入到神經(jīng)網(wǎng)絡(luò)的輸入層。

(5)表情識別。本文用15×10×2基于反向傳播的前向型神經(jīng)網(wǎng)絡(luò)進(jìn)行人臉面部表情的分析與識別。對于網(wǎng)絡(luò)參數(shù),例如隱含層神經(jīng)元數(shù)目等本文采取實(shí)驗(yàn)修正的方法。表2和表3分別是yaleface 數(shù)據(jù)庫和日本女性表情數(shù)據(jù)庫(JAFFE)上的識別結(jié)果。

參考文獻(xiàn)

1 Maja Pantic,Leon J. M .Rothkrantz. Automatic Analysis of Facial Expressions: The State of the Art, IEEE Trans. On Pattern Analysis and Machine Intelligence, 2000;2(12)

2 T. Kanade. Computer recognition of human faces. Basel &Stuttgart:Birkhauser Verlag. 1977

3 Li-Fen Chen. Why recognition in a statistics-based face recognition System should be based on the pure face portion: a probabilistic decision-based proof. Pattern Recognition, 2001;34(1):1393~1403