近日,月之暗面宣布 Kimi 開放平臺正式公測新技術——上下文緩存(Context Caching),該技術在 API 價格不變的前提下,可為開發者降低最高 90% 的長文本大模型使用成本,并且顯著提升模型的響應速度。

據了解,月之暗面是國內首家面向開發者推出上下文緩存(Context Caching)技術的大模型公司。

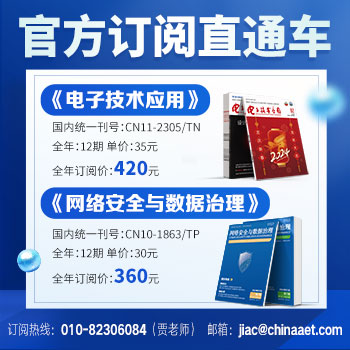

上下文緩存(Context Caching)技術的基本原理是,系統預先存儲那些可能會被頻繁請求的大量數據或信息。這樣,當用戶再次請求相同信息時,系統可以直接從緩存中快速提供,而無需重新計算或從原始數據源中檢索,從而節省時間和資源。

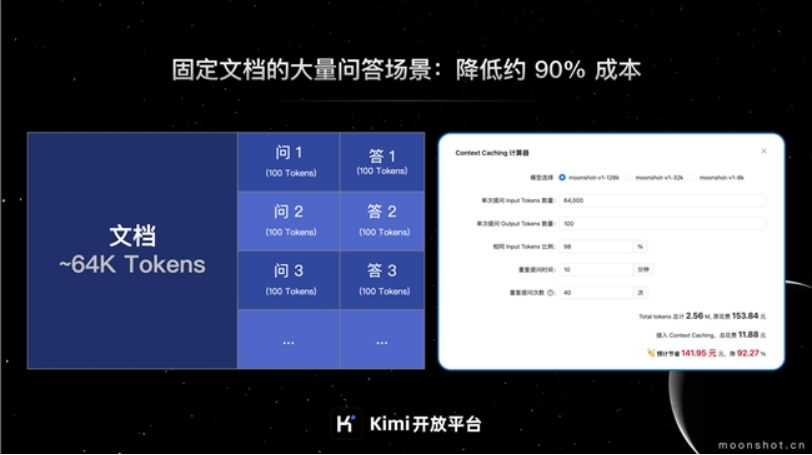

上下文緩存(Context Caching)技術可以帶來降本和提速兩大價值。首先,通過緩存重復性輸入的大量數據,對于公共上下文僅收取一次費用,上下文緩存(Context Caching)技術大大降低了開發者使用長文本旗艦大模型的成本,最高可降本達 90%。其次,上下文緩存(Context Caching)技術還有助于提升大模型API的響應速度,實測可將 128K 長文本大模型的首 token 延遲降低 83% 左右,從平均 30 秒左右降低到平均 5 秒內。

在長上下文和高負載的業務場景上,上下文緩存帶來的降本和提速效果尤為顯著。常見場景包括提供大量預設內容的問答機器人,例如 Kimi API 小助手;針對固定的文檔集合的頻繁查詢,例如上市公司信息披露問答工具;對靜態代碼庫或知識庫的周期性分析,例如各類 Copilot Agent;瞬時流量巨大的爆款 AI 應用,例如哄哄模擬器;交互規則復雜的 Agent 類應用,例如什么值得買的 Kimi+ 等。

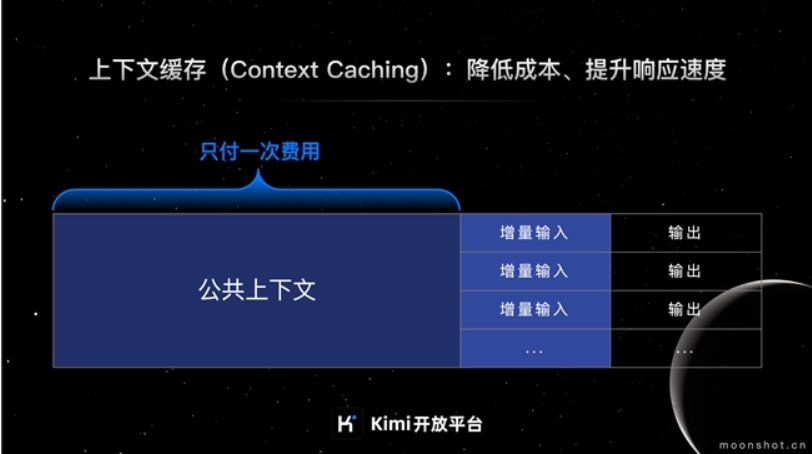

以常見的固定文檔大量提問場景為例。某硬件產品說明書大概 9萬字,換算 Tokens 長度大概 64K,該產品售前支持人員需要在 10 分鐘內,密集對產品的功能/使用方式進行 40 次問答,每次的問題大概 100 個字,要求模型的輸出需要基于產品說明書來回答,回答問題在 120 字以內。

按照大模型問答的 Tokens 計算邏輯,售前支持人員需要每次向模型輸入的 Tokens =文檔 Tokens +問題 Tokens,10 分鐘內 40 次的問答共計需要消耗 Tokens 2.56 M,128k 模型價格為 60元/M,預計原始花費需要 153.84 元。若該場景接入上下文緩存(Context Caching)技術:9萬字的文檔只收取一次創建 Cache 和存儲 10 分鐘 Cache 的費用,10分鐘內的40次提問,將只收取問題的 100 字+ 回答的 120 字的費用,預計花費 11.88 元。節省了 141.95 元,相當于費用降低 90% 左右。

響應速度方面,以 128k 模型的一次4萬字(約 30k tokens)的推理請求為例。通常向模型提問,平均要 30 秒返回首 Token。接入上下文緩存技術后,最快可 1 秒內完成首 Token 返回。經過大量測試,接入上下文緩存功能后,128k 模型的首 Token 延遲平均可降至 5 秒內,降低了 83%左右。

需要注意的是,上述測試效果基于 1 token = 1~1.5個文字和字符,使用 128k 模型進行測算。具體的效果根據業務情況/模型選擇不同,會有略微差別。

上下文緩存(Context Caching)技術在公測期間將首先提供給 Kimi 開放平臺的 Tier5 等級開發者,后續陸續增大開發者公開測試范圍。

Kimi 大模型目前已接入了釘釘、扣子等平臺,用戶或開發者可以在這些平臺選用 Kimi 大模型,借助出色的長文本和指令遵循能力搭建個性化的智能體應用。Kimi 開放平臺的開發者注冊量自從今年 2 月份以來復合增長率超過 175%,在投研服務、法律盡調、企業知識庫問答、輔助軟件開發等場景獲得廣泛應用。近期,Kimi 開放平臺陸續上線了工具調用(Tool Use)、Partial Mode、上下文緩存(Context Caching)等能力,持續幫助開發者高效打造更有想象力的AI 應用。