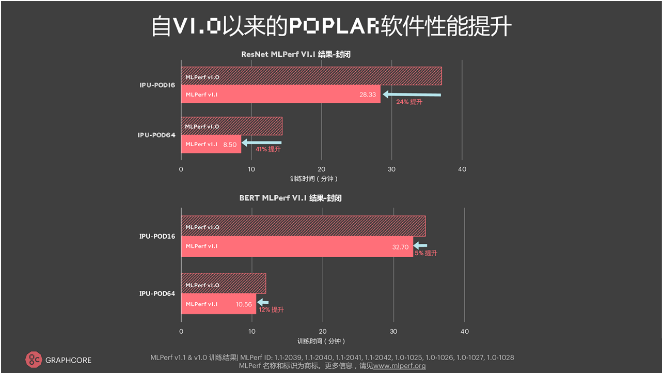

12月2日,AI芯片初創公司Graphcore(擬未科技)正式公布其參與MLPerf測試(MLPerf V1.1)的最新結果。Graphcore在本次提交了ResNet-50模型的Closed Division(封閉分區)以及BERT模型的Closed Division、Open Division(開放分區)。結果顯示,與首次提交的MLPerf訓練(MLPerf V1.0)結果相比,對于計算機視覺模型ResNet-50,Graphcore通過軟件優化,在IPU-POD16上實現了24%的性能提升,在IPU-POD64上實現了41%的性能提升;自然語言處理模型BERT在IPU-POD16上實現了5%的性能提升,在IPU-POD64上實現了12%的性能提升。此次MLPerf測試結果證明了Graphcore的IPU系統越來越強大、高效,軟件日益成熟且更快、更易使用。

Graphcore中國工程總負責人、AI算法科學家金琛指出,本次測試結果展現的性能顯著提升主要歸功于Graphcore對軟件的優化,涵蓋對應用程序、框架、系統、編譯器、核函數的優化。“這些優化在不同模型上都有所體現。大家都知道,很多事情最開始的提升速度最快,但越往后提升越困難,通常需要80%的努力才能獲得20%的提升。Graphcore能獲得這些提升,我們是做了非常多的工作的。”她表示。

Graphcore中國工程總負責人、AI算法科學家金琛

縱向對比:首次納入系統集群,ResNet-50在IPU-POD256上的訓練時間只需3.79分鐘

除了基于IPU-POD16和IPU-POD64提交的MLPerf V1.0測試,這一次,Graphcore首次納入了系統集群,進行了128顆(IPU-POD128)以及256顆(IPU-POD256)IPU集群的提交。如圖所示,ResNet-50在IPU-POD16上的訓練時間(Time to Train)為28.33分鐘,隨著系統的增大,訓練時間逐次遞減——在IPU-POD64上的訓練時間為8.5分鐘,在IPU-POD256上只需3.79分鐘。“希望明年此時,我們能提供更大的集群,讓ResNet-50的訓練時間在1分鐘之內完成,這是我們的目標。”金琛表示。

上圖顯示的是Graphcore提交的BERT-Large在MLPerf上的性能表現。“我們在IPU-POD16上的端到端訓練,在Closed Division上只需半個小時。如果把整個集群增大8倍,我們的訓練時間不到7分鐘。隨著集群的增加,訓練時間大幅縮短,這會極大提高算法工程師迭代模型的效率。在Open Division的提交方面,我們在IPU-POD64上的性能進一步提高,原因是IPU得到了優化,包括對訓練策略、對訓練優化器超參以及對損失函數的優化。如圖所示,我們基本上另外提高了20%,這非常可觀。這些優化我們也應用到了一些客戶上,得到了正面反饋。”金琛指出。

橫向對比:首次僅通過軟件實現性能提升,IPU-POD16性能優于DGX A100

MLPerf同時對比了市面上Graphcore與NVIDIA的產品。盡管GPU在ResNet-50模型上占據優勢,測試結果仍然顯示Graphcore的IPU-POD16在ResNet-50方面的表現優于NVIDIA的DGX A100。值得注意的是,這是NVIDIA生態系統在MLPerf訓練測試中的第五次亮相,而Graphcore是第二次提交。Graphcore的這次提交也是其首次僅通過軟件實現了性能提升。在ResNet-50上,IPU-POD16首次超越了DGX A100的性能,其端到端的訓練時間只用了28.3分鐘,比DGX A100快了近一分鐘。

如文章首段所提,IPU-POD16對ResNet-50的軟件驅動性能提高了24%,在IPU-POD64上對ResNet-50的軟件驅動性能提升甚至更高,達到41%,對于Graphcore具有里程碑式的意義。在金琛看來,NVIDIA的軟件庫已經迭代許久,提升的空間可能會有所減緩。Graphcore會持續迭代、優化自身的軟件棧及整個AI系統,久久為功、保持勢頭,不斷提升性能優勢。“僅通過兩次MLPerf的提交,我們就能夠在GPU最主流的模型上超過GPU,這是讓我們非常自豪的一件事,而且Graphcore在未來還有更大的提升空間。”Graphcore大中華區總裁兼全球首席營收官盧濤補充道,“以前我們一直強調IPU是一個極具創新的平臺,適合做一些新的應用,幫助創新者完成他們曾經達成不了的任務。這次的測試結果證明IPU確實能在已經成為主流的應用上落地,能落地則意味著可觀的商業回報,這也是對行業而言比較重要的一個影響。”

Graphcore大中華區總裁兼全球首席營收官盧濤

大規模集群性能擁有強大優勢

本次Graphcore提交的集群是IPU-POD128和IPU-POD256。除了IPU-POD16和IPU-POD64的時間優勢之外,IPU-POD128和IPU-POD256此次能取得優異成績主要在于其軟件的可擴展性。“我們在設計軟件的過程中考慮了很多因素,比如大量優化模型變形、數據變形、Kernel變形。同時,我們擁有非常細致的設計思路,讓用戶只需要寫一個腳本、配置數據Replica的個數,就可以很自如地進行從1個IPU到256個IPU的橫向擴展。”金琛指出,“除了在框架層面進行橫向擴展,我們也在通信庫上做了很大一部分優化。這方面的優化會為深度學習以及數據并行的深度學習帶來顯著影響。關于BERT-Large訓練中5%和12%的提升很大程度上源于我們對通信庫的改進。”

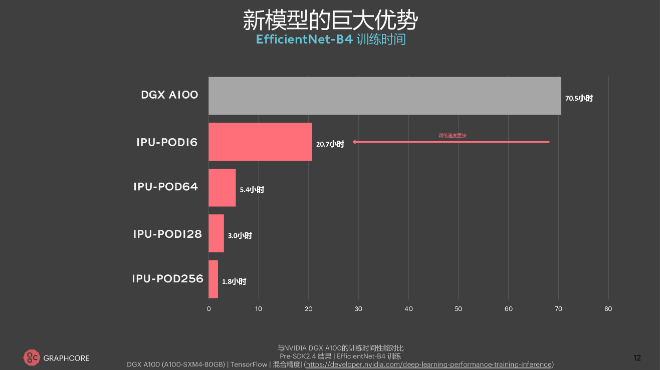

據介紹,Graphcore的系統擴展可以應用在更廣泛的應用場景之中,包括用于自然語言處理的GPT類模型和用于計算機視覺的ViT(Transformer視覺模型)。“我們的系統軟件設計及優化對新模型、新架構均非常適用。IPU系統可以非常平滑地從16個IPU一直擴展到256個IPU。”金琛表示。

以創新的計算機視覺模型EfficientNet-B4為例,DGX A100端到端的訓練時間為70.5小時(官網數據),而IPU-POD16端到端的訓練時間是20.7個小時,前者約為后者的3.5倍。隨著系統的增大,時間逐漸縮短,EfficientNet-B4在IPU-POD256上的訓練時間僅為1.8小時。“盡管這并非Graphcore本次向MLPerf提交的內容,但我們的大規模集群在實際應用中的確具備更強的性能優勢。原來4天的訓練時間現在只需2個小時,這會大大解放開發者的生產力,是我們大集群非常大的一個吸引力。”金琛解釋。

“我們第一版IPU-POD的硬件是在2020年的12月份宣布量產的。一年內的硬件集群的增加、軟件的優化,使得我們此次在IPU-POD256上的ResNet性能相較去年年底在IPU-POD16上的ResNet性能提高了50倍,這是一個非常大的飛躍。”盧濤認為,“我們的生態在過去半年中也取得了長足進步,擁有越來越多跨行業的商業用戶、商業案例研究,例如天氣預測、金融、保險、電信。”

回顧2021,盧濤指出,其自身遇到的最大的挑戰可以用三個字來形容——“周期比預期要長”。不過,正如錘煉一柄傳世寶劍,以精益求精之決心,歷經千錘百煉后才能鍛造出去雜存精的好劍。鑄劍的過程是痛苦的,但寶劍內在美好的本質會被錘煉出來。這時,挑戰亦為收獲。“2021年我們確實扎根產業,著力落地應用場景,但整體來說,AI應用場景落地的整個鏈條很長,因此把整個方案變為一個產品是個挑戰。”盧濤告訴記者。

兼具通用性與高性能,IPU發展經歷了“熱鬧的2021”,將迎來“美好的2022”

在盧濤看來,2021年IPU的市場環境存在兩個特點:第一是應用落地時間長于預期;第二是市場對IPU的期望強于預期。“今年年底時,我們發現市場的動能、慣性以及活躍程度,比年初時更為看好。這背后的原因在于多種因素組合所帶來的積極推動作用,例如用戶對市場、對自己應用的認知,對市場上各類處理器的認知,還有我們自身框架、應用、生態以及落地場景等方面的進展。隨著更多資金的投入,2021年的市場環境將比2020年更為熱鬧。”盧濤告訴記者。

他指出,無論從計算機的體系結構抑或是用戶角度來講,IPU都極具通用性:“從指令級、架構上來看,IPU能夠進行所有AI相關的業務,從CNN、RNN到LSTM,再到Transformer,所以IPU的通用性毫無疑問。假如不講計算機的體系結構,用戶判斷產品的通用與否主要依據以下兩點:第一、產品是否能開發出各種各樣的應用。如果不同的應用都能開發,那么對用戶而言它就通用。第二、對開發者來說,產品是否便于針對各種應用進行編程。如果能夠編程,那么對開發者而言它就通用。所以從這兩個維度來看,IPU是一個非常通用的產品。”

除此之外,高性能也是IPU吸引用戶的關鍵因素。據介紹,在金融案例中,Graphcore的IPU產品比GPU快10倍;在保險算法模型方面,IPU比GPU快5倍;天氣預測方面,歐洲案例證明IPU比CPU快50倍、比GPU快5倍;中國目前的場景顯示IPU能夠比CPU快60倍。“最近,斯坦福大學醫學院在差分隱私的使用方面取得了重大突破。通過使用Graphcore IPU,斯坦福團隊能夠將具有差分隱私的人工智能訓練速度提高10倍以上。IPU支持隱私計算非常吸引他們。”盧濤補充。

談及IPU的技術發展趨勢,盧濤指出以下三點:

第一,“Transformer-based everything”(基于Transformer的一切);

2017年,谷歌團隊首先提出Transformer模型,該模型最初被應用于NLP領域,成效卓著。如今在計算機視覺領域、對話和語音領域,Transformer同樣表現優異。隨著GPT-2、GPT-3、AlphaStar等更多大模型重要成果的顯現,Transformer預計會為更多領域帶來革新。

第二,應用規模會越來越大、越來越復雜;

“之前大家比較關注單一的視覺任務和語音任務,后來AI又能應用于文字、語言、視頻、圖像,更加復雜,所謂稱之為‘多模態’,這是一個重要趨勢。”盧濤做出解釋。

第三,AI融合科學計算。

盧濤表示,目前AI正在從互聯網、自動駕駛等熱門場景向與傳統科學計算相結合的方向發展。例如DeepMind今年發布的AlphaFold(蛋白質方面的科學研究)、AI用于天氣預測、宇宙學研究、分子動力學仿真等等。

基于此,盧濤表示,2022年Graphcore會相應地在三點進行發力:

第一,加大基于Transformer的應用上的投入。

ResNet于2016年10月發明,BERT于2018年10月出現。因此,自2016年5月成立以來,Graphcore在基于Transformer的應用方面呈持續追趕態勢。“我們處于追趕當前市場霸主的位置,別人已經打磨很久了、做了大量的優化和工作。”盧濤表示,“即便這樣,我們甚至只跟目前產業最領先的企業在transformer上只有三個月的差距。所以我們會在Transformer-based everything方面加大投入。”

第二,混合語言、語音、視頻、圖片,用AI進行更復雜的應用。

第三,加大對AI與高性能計算、科學計算融合的投入。

企業的技術提升離不開人才建設,因此Graphcore也會持續加強人才儲備。2021年初,Graphcore中國團隊只有20人左右,截至目前,團隊人數增長四倍,達到80人。從全球來看,公司總人數也從年初的400多人增長至如今的600多人。據了解,隨著AI在科學計算上的應用逐漸普適化,Graphcore也會在科學計算方面儲備人才。“天氣預測、分子動力學等領域會給國計民生帶來深遠影響,所以不光在深度學習,我們也會在高性能計算領域與大家一同開拓創新。”金琛告訴記者。“我們會腳踏實地,認真務實,相信Graphcore‘擬未’會有更美好的未來。”盧濤在最后總結。